一、竞赛背景

网络货运平台兴起,如何通过大数据、物联网、人工智能等新兴技术,实现物流行业降本增效,一直是平台追求的目标。物流大数据主题竞赛旨在通过网络货运平台真实运单、订单、车型、位置等脱敏数据,利用工具软件和大数据挖掘与优化方法,在车货匹配、线路优化、客户需求分析等问题上寻求解决方案。

二、竞赛规则

1. 数据来源

大赛数据为共生物流平台运营数据,共生物流平台为交通部“无车承运人试点企业”和工信部“大数据产业发展试点示范企业”,以先进技术建立B2B2车全链条物流互联网交易,提供物流运营、采购、销售、资金、财务、创业、人力资源共享等方面互联网支持服务,以共享提升物流服务和效率。

2. 竞赛选题

在“交通大数据”主题竞赛类下,“物流大数据”竞赛方向围绕共生物流平台运营案例数据,设置车货匹配、车车联动、客户需求分析3个题目,参赛团队可任选其一,依据大赛组委会提供数据样本完成问题解决与作品设计。

参赛团队可使用各种优化工具进行问题的辅助解决,本次比赛主办方提供Supply Chain Guru X供应链优化工具(含运输优化模块)和PMT大数据挖掘工具,参赛团队可酌情使用。

3. 提交结果形式

为了便于评委了解作品及其技术细节,在作品提交截止日期前,各团队需要提供以下内容:

(1)模型文件或完整代码文件,结果输出文件;

(2)结题报告;

结题报告须对以下方面内容进行详细说明:

(1)研究背景:介绍研究的由来、意义、环境、状态、前人研究成果以及当前具有的条件等基础信息。

(2)研究数据支撑:介绍作品所使用到的比赛数据,并详细说明这些数据的使用情况。

(3)研究内容:对作品研究的内容进行梳理介绍。

(4)研究技术路线:详细介绍研究的方法、工具和手段,说明研究的流程。

(5)研究结果:对研究的结果进行完整、详细、清晰表达。

(6)研究总结:对研究的问题、过程及成果进行总结。

4. 评比规则

本次大赛坚持公开、公平、公正的原则对所有符合要求的参赛作品进行评审,评审内容包括:

(1)作品报告完整性(分数占比10%)

(2)研究成果的合理性、准确性和实用性(分数占比45%)

(3)研究方法的科学性、先进性和创新性(分数占比45%)

三、竞赛组织

“物流大数据”竞赛方向属于“交通大数据”主题竞赛类的方向之一,其参赛要求、组织程序和评审办法参照《“新国线杯”第十五届全国大学生交通运输科技大赛实施方案》执行,优秀作品将有机会入围“交通大数据”主题竞赛类决赛答辩。

赛题一

数据表包含“车货匹配-车型数据.txt”、“车货匹配-地址数据.txt”、“车货匹配-运单数据.txt”、“车辆基础数据.txt”、“位置基础数据.txt”,数据样例如下。其中车辆GPS数据在“位置基础数据.txt”中给出了下载地址。

表1-1 车货匹配-运单数据

| ID | 运单编号 | 要求提货时间 | 要求到货时间 | 总方数 | 总吨位 | 总里程(km) |

|---|---|---|---|---|---|---|

| 303307 | 20180402350177 | 2018-4-2 14:00:00 | 2018-4-2 16:00:00 | 30 | 7 | 140 |

表1-2 车货匹配-地址数据

| ID | 运单ID | 类型 | 省 | 市 | 区 | 地址 | gpsX | gpsY | 主节点 | 顺序 |

|---|---|---|---|---|---|---|---|---|---|---|

| 945126 | 348222 | 提货 | 广东 | 广州 | 天河区 | 广州市沙太南路342号 | 113.3348 | 23.17639 | 1 | 0 |

表1-3 车货匹配-车型数据

| ID | 运单ID | 车长(米) | 车板 |

|---|---|---|---|

| 310905 | 303307 | 6.8 | 敞车 |

| 372403 | 348222 | 9.6 | 厢车 |

表1-4 车辆基础数据

| ID | 车牌 | 车长(米) | 车型 | 最大吨数 | 最大方数 |

|---|---|---|---|---|---|

| 24656 | 周BX**X2 | 17.50 | 厢车 | 120.00 | 45.00 |

表1-5 车辆GPS数据

| vhc | gpsX | gpsY | gpsTime | province | city | area | address | Speed(km/h) |

|---|---|---|---|---|---|---|---|---|

| 100990 | 120.10205200 | 30.09923000 | 2018-06-30T23:59:39.000Z | 浙江省 | 杭州市 | 西湖区 | [APP_IOS]G25长深高速 | 69.58799743652344 |

赛题二

数据表包含“车车联动数据.xls”,包含订单数据,接驳网点,提货车辆数据三个子表,数据样例如下。

表2-1 车车联动-订单数据表

| ID | 预约提货时间 | 提货省份 | 提货市 | 提货区 | 提货地址 | 重量(吨) | 体积(方) | gpsX | gpsY |

|---|---|---|---|---|---|---|---|---|---|

| 1 | 1/26/2018 09:00:00 | 广东 | 广州 | 白云区 | 庄中路XX号 | 0.02 | 0.282 | 39.09316 | 43.739998 |

表2-2 车车联动-提货车辆信息表

| ID | 车牌 | 车长(米) | 车型 | 最大吨数 | 最大方数 |

|---|---|---|---|---|---|

| 25339 | 下A6**F5 | 4.2 | 厢车 | 10 | 3 |

表2-3 车车联动-城市接驳网点信息表

| ID | 网点名称 | gpsX | gpsY | 地址 |

|---|---|---|---|---|

| 1 | 接驳点A | 103.983361 | 30.506996 | 四川省成都市双留区腾飞十二路971号 |

赛题三

提供2018年1月1日-2019年6月30日的数据作为训练数据集;2019年7月1日-2019年7月31日为需要预测的时间段。参赛者须基于此完成赛题。

数据内容详见“客户需求分析-地址数据(客户A).txt”、“客户需求分析-地址数据(客户B).txt”、“客户需求分析-运单数据(客户A).txt” 、“客户需求分析-运单数据(客户B).txt”。

表3-1 客户需求分析-运单数据

| ID | 运单编号 | 要求提货时间 | 要求到货时间 | 总方数 | 总吨位 | 承运车辆 |

|---|---|---|---|---|---|---|

| 1 | 20180608907951 | 2019-12-13 00:00:00 | 2019-12-14 23:59:00 | 16 | 1.6 | 1 |

表3-2 客户需求分析-地址数据

| ID | 运单ID | 类型 | 省 | 市 | 区 | gpsX | gpsY | 主节点 | 顺序 |

|---|---|---|---|---|---|---|---|---|---|

| 609626 | 247816 | 提货 | 陕西 | 咸阳 | 礼泉县 | 108.4826 | 34.59785 | 1 | 0 |

| 609627 | 247816 | 卸货 | 陕西 | 西安 | 雁塔区 | 109.0134 | 34.24416 | 1 | 0 |

Supply Chain Guru X 供应链设计工具

Supply Chain Guru X 供应链设计工具

1、工具简介

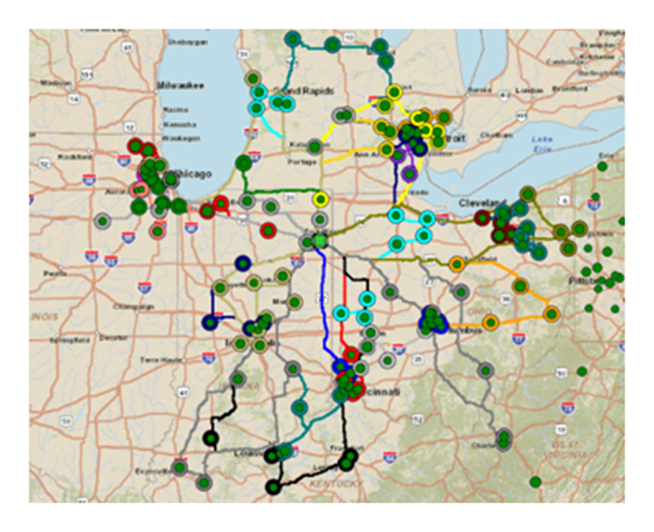

Supply Chain Guru X(SCGX)供应链设计工具可以系统化建立“数据驱动”的供应链模型,并通过云计算、数据集成管理、模拟仿真、数据可视化等技术手段,诊断和分析供应链存在的问题,并基于优化目标输出优化结果,解决供应链网络优化、库存优化、产销协同、运输优化等方面的问题。

2、工具说明

Supply Chain Guru X集成网络优化、库存优化、运输优化和模拟仿真四大优化引擎。其中,利用其运输优化模块,能够在综合考虑各种成本、时间限制、车辆资源、交通限制、运输资源的条件下,进行多点路径优化。

图1 多站点运输线路优化

可为以下经典问题设计解决方案:

(1)取货运输任务整合

(2)配送运输任务整合

(3)周期运输任务平衡及排车计划

(4)回程优化

(5)配送及取货任务交错的线路

(6)车辆数量优化

(7)通过中转场地优化运输任务

3、建模过程

运输优化建模包含5个步骤:

图2 运输优化建模流程

(1)目标规划:包含运输优化问题的分析及目标设定、运输优化模型假设、运输优化场景设定。

(2)数据收集:包括数据分析维度确定、数据获取与数据清洗、数据导入与映射关系。

(3)基准模型构建:构建并验证基准模型。

(4)场景设计与分布:包括应用场景设计、建模与分析。

(5)分析总结:分析并总结问题,给出建议决策。

PMT大数据挖掘工具

PMT大数据挖掘工具

1、工具简介

PMT数据挖掘工具采用可视化建模的设计思路(即用图形化的方法,来建立整个挖掘流程),支持数据预处理、数据探索性分析、建立模型、模型评估、模型应用整个数据挖掘过程,在建立模型的核心模块,提供解决分类预测、回归预测、聚类分析、关联规则、序列分析、异常检测等数据挖掘问题的主流算法,并且具有可拓展性功能,通过编写Python脚本的方式,实现自定义分析功能。

2、工具说明

PMT对数据按照特定的方式方法进行分析处理,发现隐藏在数据背后的问题和规律,包含从原始数据的预处理、加工、挖掘、分析到发现规律,最后再到结果可视化呈现的全过程。具备数据描述与理解功能、数据获取与组织功能、数据挖掘建模功能。

封装了包括机器学习、数据预处理和数据可视化等组件,目标是以一种最为简约的方式来解决具体业务场景中的问题,所提供的核心功能如下:

(1)数据预处理:数据记录选择、数据特征选择、数据标准化、缺失值处理、PCA降维、数据合并、离散化、异常值处理等;

(2)数据可视化:直方图、箱线图、树图、散点图、维恩图、地图、序列图、相关图等;

(3)数据建模:多元回归、决策树、逻辑回归、神经网络、ARIMA、随机森林、支持向量机、关联规则、聚类算法等;

图3 数据挖掘分析流程

(1)数据预处理:数据预处理的目的是让数据适应模型,匹配模型的需求,包括数据转换,数据集成等处理内容;

(2)数据探索:数据探索是对建模分析数据进行先导性的洞察分析,利用绘制图表、计算某些特征量等手段,对样本数据集的结构特征和分布特性进行分析的过程;

(3)建立模型:数据挖掘的核心阶段是基于既定的数据和分析目标选择适宜的算法模型进行建模训练和迭代优化;

(4)模型评估:模型评估是评估所构建的模型是否符合既定的业务目标,它有助于发现表达数据的最佳模型和所选模式将来工作的性能如何。模型评估秉承的准则是在满足业务分析目标的前提下优先选择简单化的模型;

(5)模型应用:模型部署及应用是将数据挖掘结果作用于业务过程,即将训练得到的最优模型部署到实际应用中。